27 мая 2024 года произошло событие, вызвавшее значительный резонанс в диджитал-сообществе — слив внутренних данных о SEO-алгоритмах компании Google. Обнародование этих материалов открыло множество интересных деталей о факторах ранжирования в выдаче поисковика и принципах работы с ними, используемых компанией.

Наша команда SEO-специалистов тщательно изучила эти материалы и вместе с редакцией подготовила для вас подробный анализ. Читайте о главных информационных находках, которые удалось добыть по результатам утечки, и их влиянии на принципы оптимизации сайтов!

Как материалы Google оказались в Сети

Коротко расскажем, как вообще обнаружилась утечка сведений. Документы о работе алгоритмов поиска Google оказались совершенно случайно доступны на GitHub в марте 2024 года. Эти документы известны как Google Search Content Warehouse API, они содержат внутренние данные, в частности, о системе ранжирования в поисковике и о других его функциях.

Документация оставалась в публичном доступе до мая 2024 года. Потом Google удалил ее оттуда. Однако за это время файлы, разумеется, успели скачать и проиндексировать при помощи сторонних сервисов. Это позволило сохранить полученные сведения даже после удаления.

Главные находки, полученные при утечке

Сложность и глубина данных

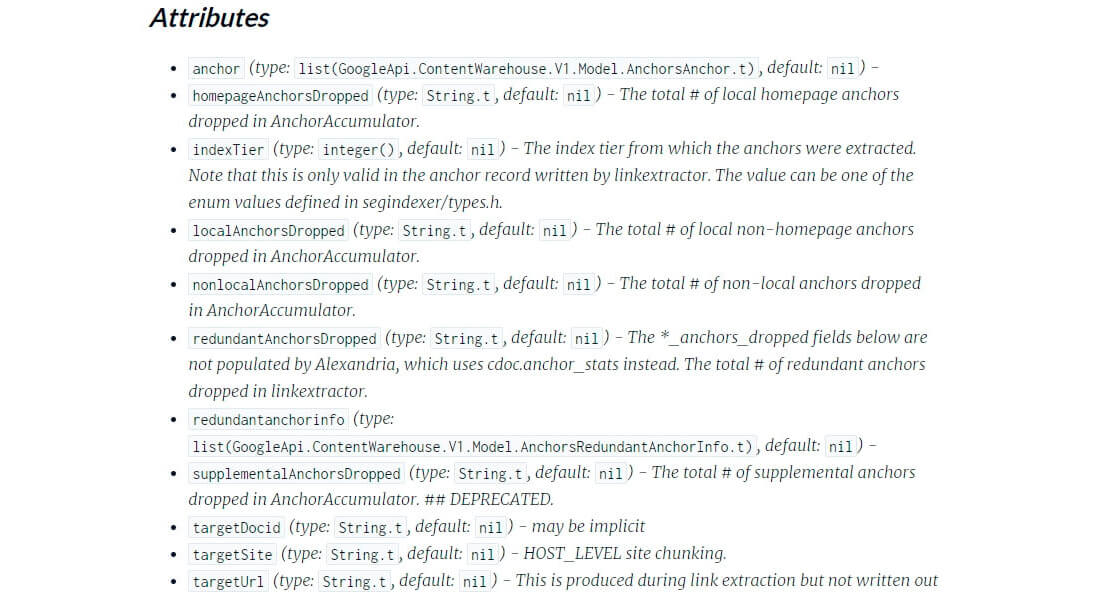

Обнародование документации подтвердило, что Google учитывает при анализе огромное множество факторов, имеющих отношение к контенту, ссылкам, взаимодействиям пользователей.

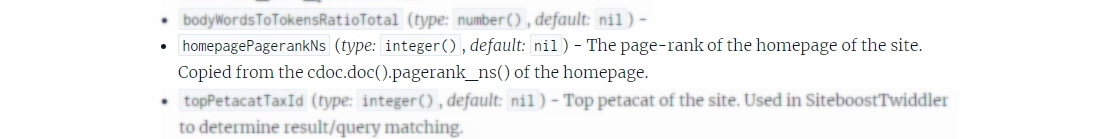

По указаниям экспертов, в слитых документах описано более 14 000 различных факторов и модулей (наподобие PageRank), которые играют важную роль в алгоритмах ранжирования поисковика. При этом данные показывают, что работа PageRank главной страницы сайта влияет на этот показатель у всех страниц (документов) веб-ресурса.

Отсюда можно сделать вывод о важности комплексного подхода в вопросах оптимизации. Он включает как создание качественного контента, так и получение высококачественных обратных ссылок. Наш кейс о помощи заказчику в увеличении трафика и конверсий является ярким примером эффективности такого подхода.

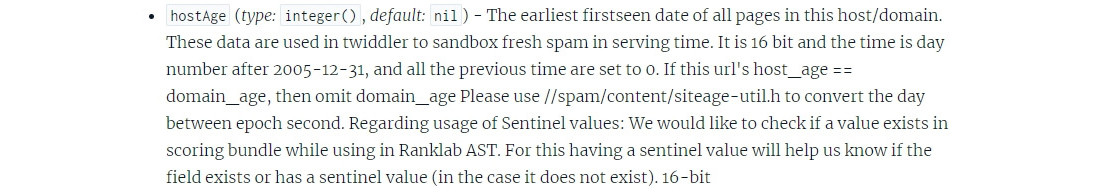

Существование «песочницы» (Sandboxing)

Также найденные документы подтвердили, что Google применяет для новых или ненадежных сайтов механизм использования в песочнице (sandboxing). Т. е. ограничивает их видимость, пока они не докажут свою легитимность и качество в целом.

Это подтверждается наличием атрибута "hostAge" в модуле PerDocData, который используется для временной изоляции свежего спама.

Данная информация особенно важна для владельцев новых сайтов. Она наглядно подчеркивает, насколько необходимо быстро создавать качественный контент (работать над поведенческими факторами) и получать доверительные сигналы от целевой аудитории, в том числе через ссылки на страницы.

Использование данных Chrome и других сервисов

Несмотря на публичные заявления Google о том, что данные о пользовательском поведении в браузере Chrome не используются при ранжировании, утечка документов компании показала: это не так, они действительно учитываются (и активно).

Например, модуль ChromeInTotal использует информацию о взаимодействиях пользователей для оценки качества страниц и других факторов ранжирования.

Таким образом, становится очевидной роль оптимизации производительности сайта и улучшения пользовательского опыта. Кстати, в одном из наших проектов оптимизация сайта, целью которой были быстрая загрузка страниц и удобная навигация, привела к значительному увеличению количества заказов: на 439% за полгода.

Влияние на SEO-стратегии

Наконец, утечка конфиденциальных сведений Google в Интернет подтвердила значимость таких параметров, как качество и актуальность контента, интуитивная навигация по сайту (Navboost), а также регулярное обновление контента.

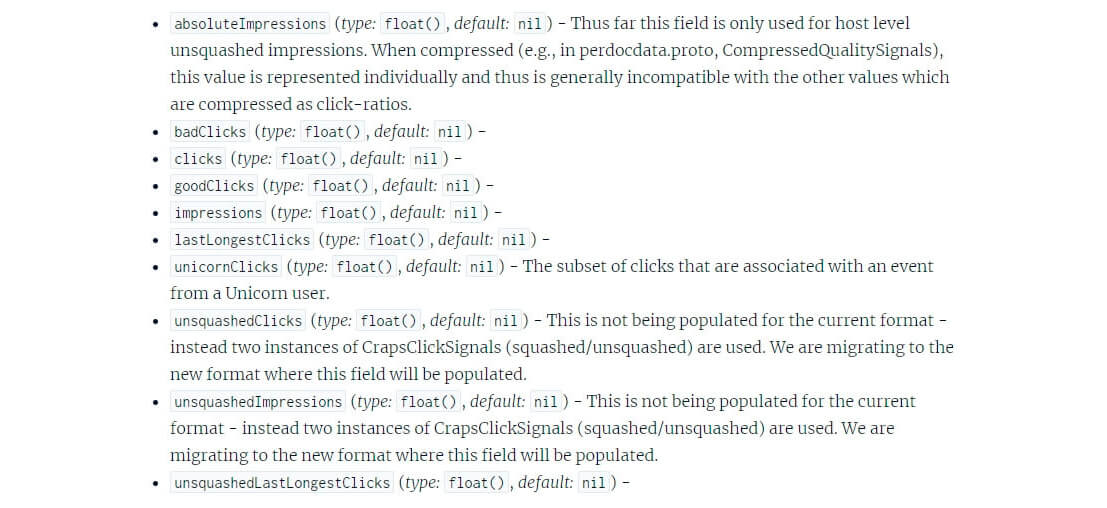

Google стабильно применяет ряд метрик — goodClicks, badClicks, lastLongestClicks — чтобы определять степень удовлетворенности целевой аудитории и соответствия страниц ее запросам. Оценивается, к примеру, CTR (кликабельность) и подобные показатели.

Отсюда видно, как важно постоянно улучшать контент на страницах и принципы взаимодействия с пользователями. В частности, мы в одном из кейсов (о разработке нового сайта для международной логистической компании) еще на этапе проектирования учли результаты анализа SEO-факторов. За счет чего сайт получил заметно более высокий уровень доверия — это положительно сказалось на ранжировании.

ТОП-1 в рейтинге веб-студий, 10+ лет опыта, 800+ проектов. Мы знаем, как продвигать сайты любых тематик и конвертировать посетителей в покупателей. Первые результаты — через 1 месяц после начала работ.

Erid: 2VtzqvyYhxb

Дополнительные выявленные алгоритмы и их влияние на ранжирование

- Navboost и Twiddlers: модули, упомянутые в слитой документации как значимые на этапе окончательного ранжирования документов. Корректируют результаты поиска на основе пользовательских взаимодействий, помогают улучшить разнообразие и релевантность результатов поиска.

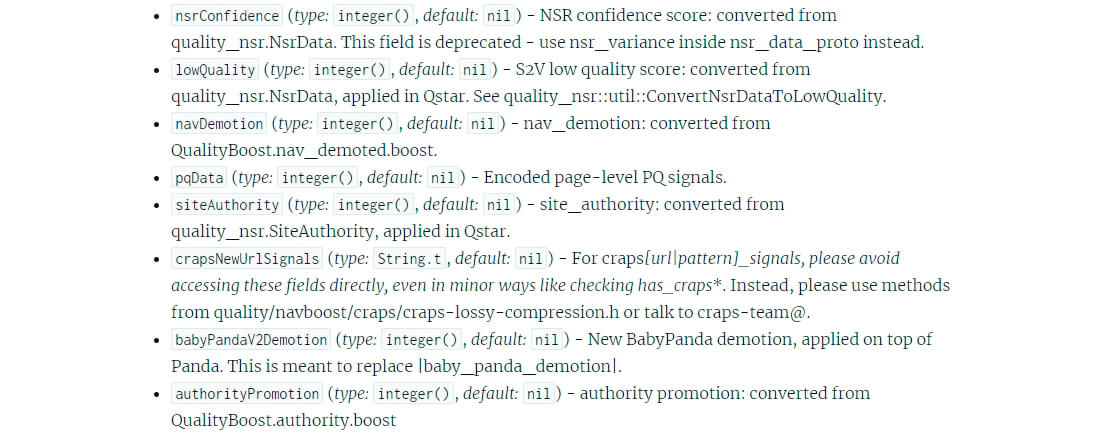

- Neural Semantic Retrieval (NSR): алгоритм, улучшающий способность роботов Google понимать контекст и смысл пользовательских запросов. Это позволяет предоставлять более точные и релевантные результаты при ранжировании (т. е. важно создавать контент, который точно отвечает на запросы).

- Авторитетность сайта (Site Authority): механизм, демонстрирующий, что доверие и авторитетность сайта играют весьма значительную роль в ранжировании. Он подтверждает важность создания качественного контента и получения авторитетных обратных ссылок в ходе повышения видимости сайта в поиске.

Заключение

Слитые документы от Google — крайне ценный ресурс для оптимизаторов. Он позволяет адаптировать стратегии для соответствия новым стандартам и требованиям поисковой системы.

Ряд успешных кейсов, реализованных в нашей компании, показал, что мы уже давно интуитивно учитываем подходы Google и движемся в правильном направлении. Выявленная информация позволит нам закрепить этот подход, опираясь на полезные материалы о сервисах, использование которых Google ранее отрицал.